我正在测试 Clever AI Humanizer 来让我的 AI 生成文本听起来更自然,但我不确定它在真实使用场景中是否真的效果良好。有些输出仍然让人感觉很机械,我也担心检测工具会标记我的内容。有没有人可以分享一些真实的使用体验、优缺点,以及使用这个工具获得最接近人类表达效果的技巧?

Clever AI Humanizer:我的真实体验与测试结果

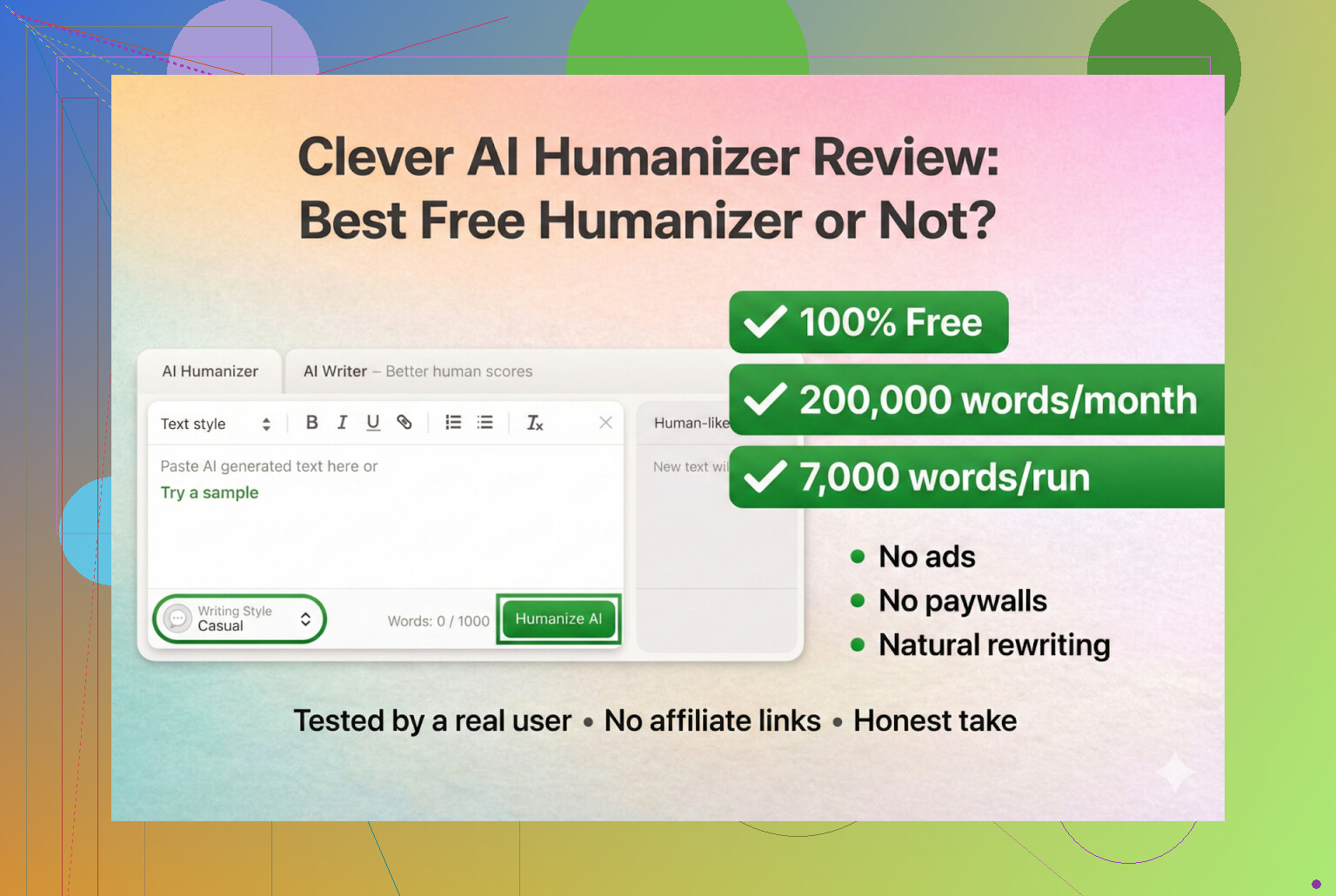

最近我彻底钻进了 AI “人性化处理”工具的兔子洞,但我想先从完全免费的东西开始。第一站:Clever AI Humanizer。

网站在这里,就我目前看到的情况,这个应该才是正版:

Clever AI Humanizer — 最佳100%免费人性化工具

我特地把网址写清楚,因为我已经见过不少人被山寨站和乱七八糟的“humanizer”工具坑了——这些工具在 Google Ads 里抢同一个品牌词。用户点了广告,跳到一个完全不一样的网站,结果莫名其妙就被绑进了付费订阅。

截至目前,Clever AI Humanizer 本身没有任何付费版本。没有加售页面,没有“升级到专业版”,没有偷偷订阅。如果有“Clever Humanizer”在向你要信用卡,你几乎可以肯定已经不在正版网站上了。

我是怎么测试的

我不想做那种给自己乱七八糟的笔记润色的“温柔测试”,我直接上了 AI 打 AI 的玩法。

- 先让 ChatGPT 5.2 写了一篇完全由 AI 生成的 Clever AI Humanizer 介绍文章。

- 把这份原始 AI 文本丢进 Clever AI Humanizer。

- 在 Humanizer 里选择 Simple Academic(简洁学术) 模式。

- 用好几个 AI 检测器跑一遍结果。

- 再让 ChatGPT 5.2 对最终文本做质量点评。

为什么选 Simple Academic?因为这种风格对很多“humanizer”来说特别难搞。太学术很容易触发检测器,太口语又容易显得很假。这种介于中间的风格:用词略偏学术,但又不是论文腔。我猜这种混合风格有助于降低检测分,同时又保持可读性。

检测器测试:它真的能“过检”吗?

ZeroGPT

对 ZeroGPT 我是又爱又恨。它曾经把美国宪法判成“100% AI”,这其实已经很能说明它的可靠性了。话虽如此,它依然是最流行的检测器之一,在 Google 上排名也很靠前,所以无论我们喜不喜欢,大家都还在用。

在 Clever AI Humanizer 输出的文本上,ZeroGPT 的结果是:

0% AI

也就是说:检测为完全人类文本。

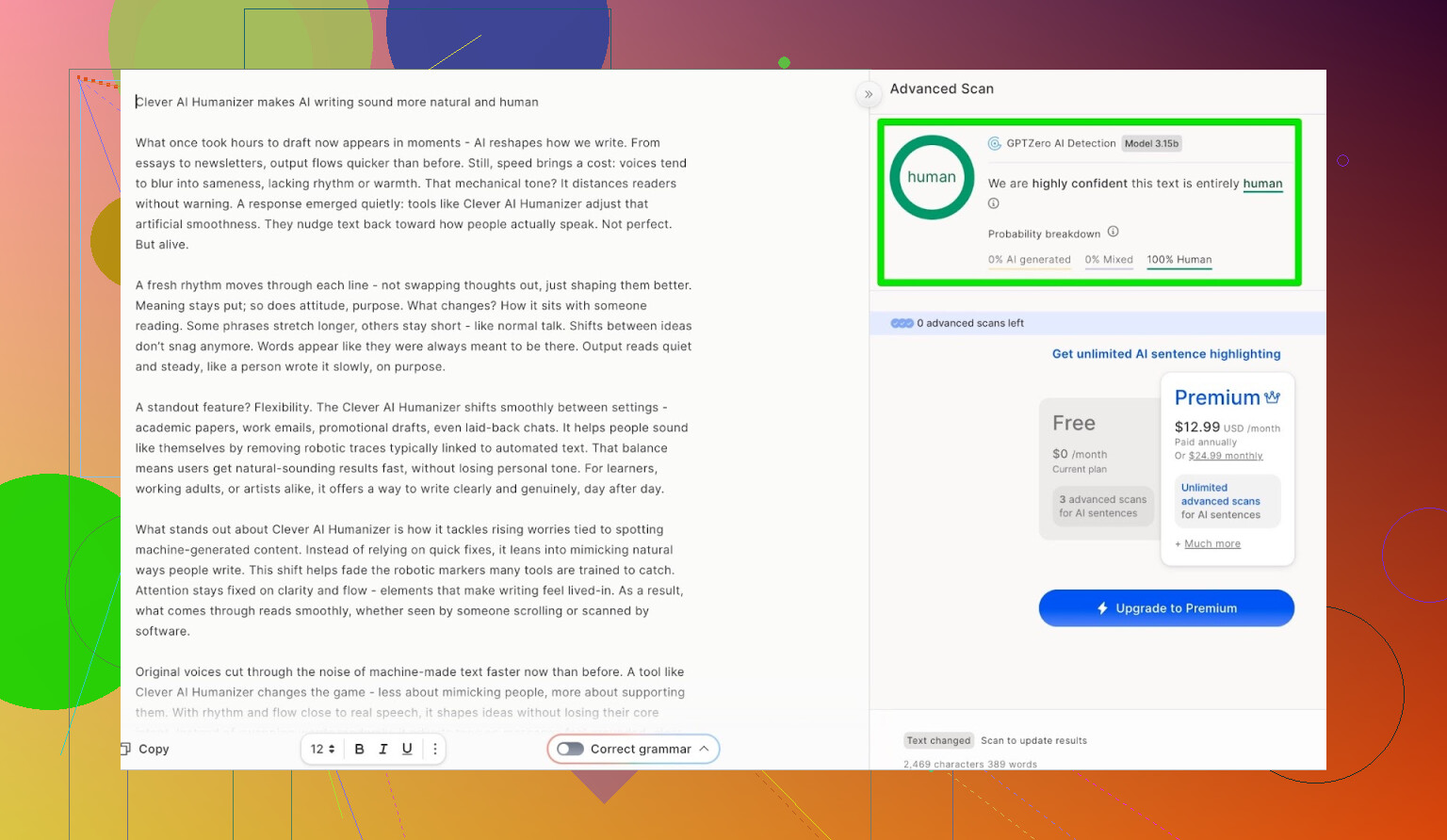

GPTZero

接着我把同一段文本丢进另一个大名鼎鼎的检测器 GPTZero。

结果:

100% human,0% AI。

同样是几乎完美通过。

所以就首次测试的原始检测分来看,它在这两个最常用检测器上都表现得非常好。

但文本本身到底好不好?

如果输出读起来像打乱顺序的教科书,或者像被来回机翻了三次,就算“过检”也没意义。

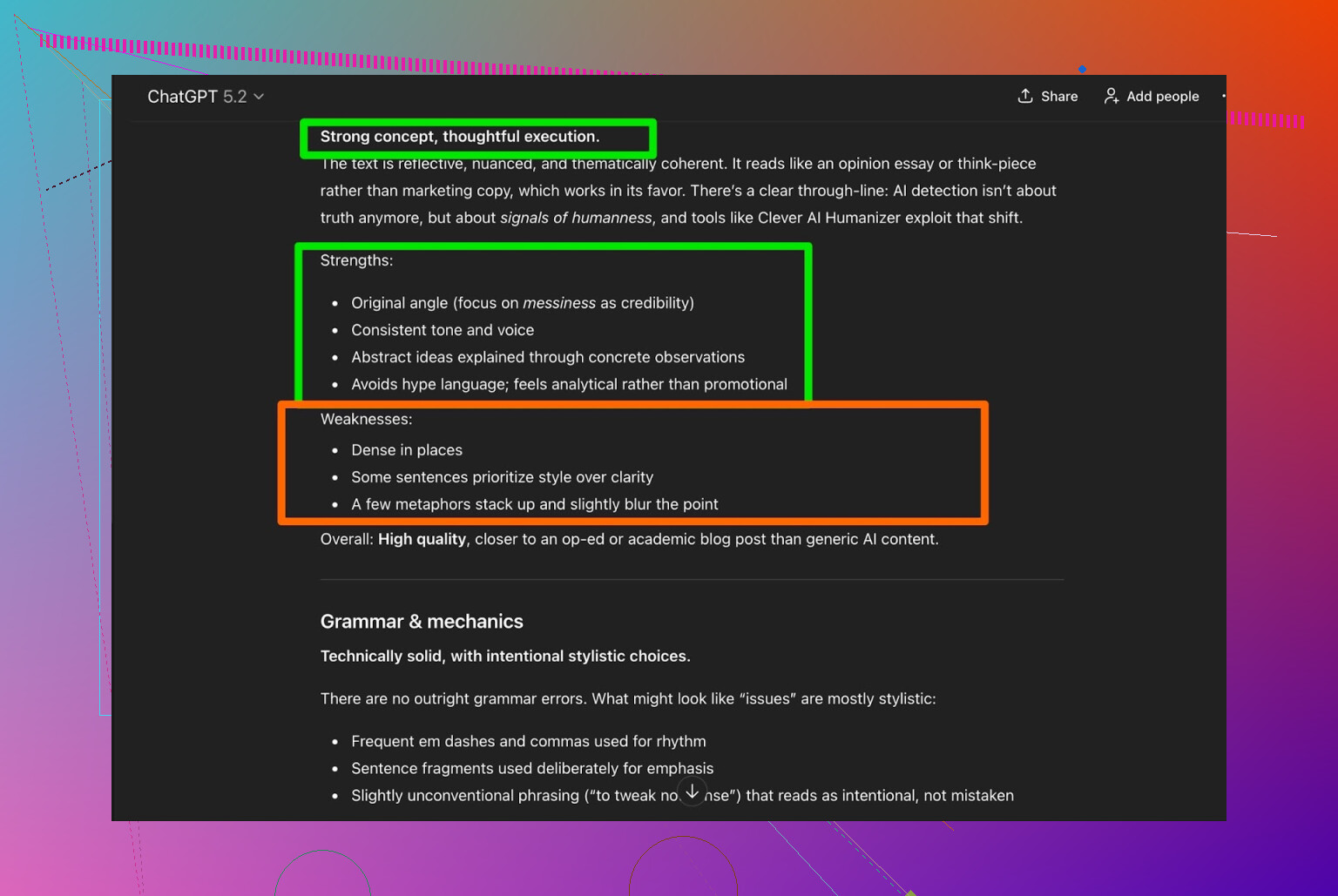

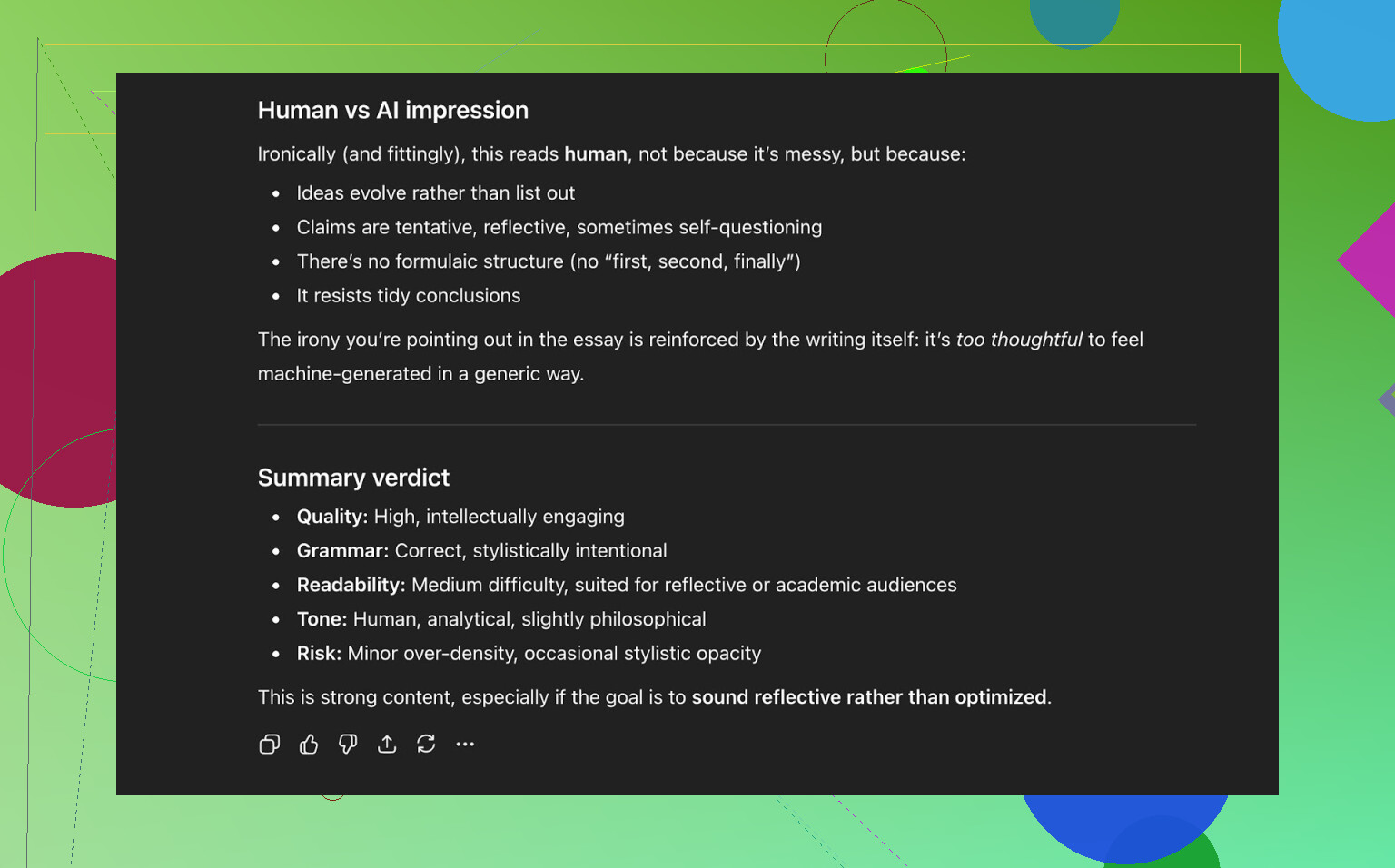

于是我把 Clever AI Humanizer 处理后的最终版本又丢回给 ChatGPT 5.2,让它从以下角度打分:

- 语法

- 连贯性

- 风格一致性

- 是否仍然需要人工编辑

ChatGPT 5.2 的结论:

- 语法:扎实

- 风格:符合 Simple Academic,但

- 仍然建议在发布前做一遍人工审稿

这个结论我个人觉得挺合理。任何敢承诺“完全不需要编辑”的工具基本都在画饼。无论是 AI 改写、humanizer、AI 写作工具,最后你还是得自己:

- 针对你的具体读者调整语气

- 删掉奇怪的措辞

- 核实事实

- 微调结构

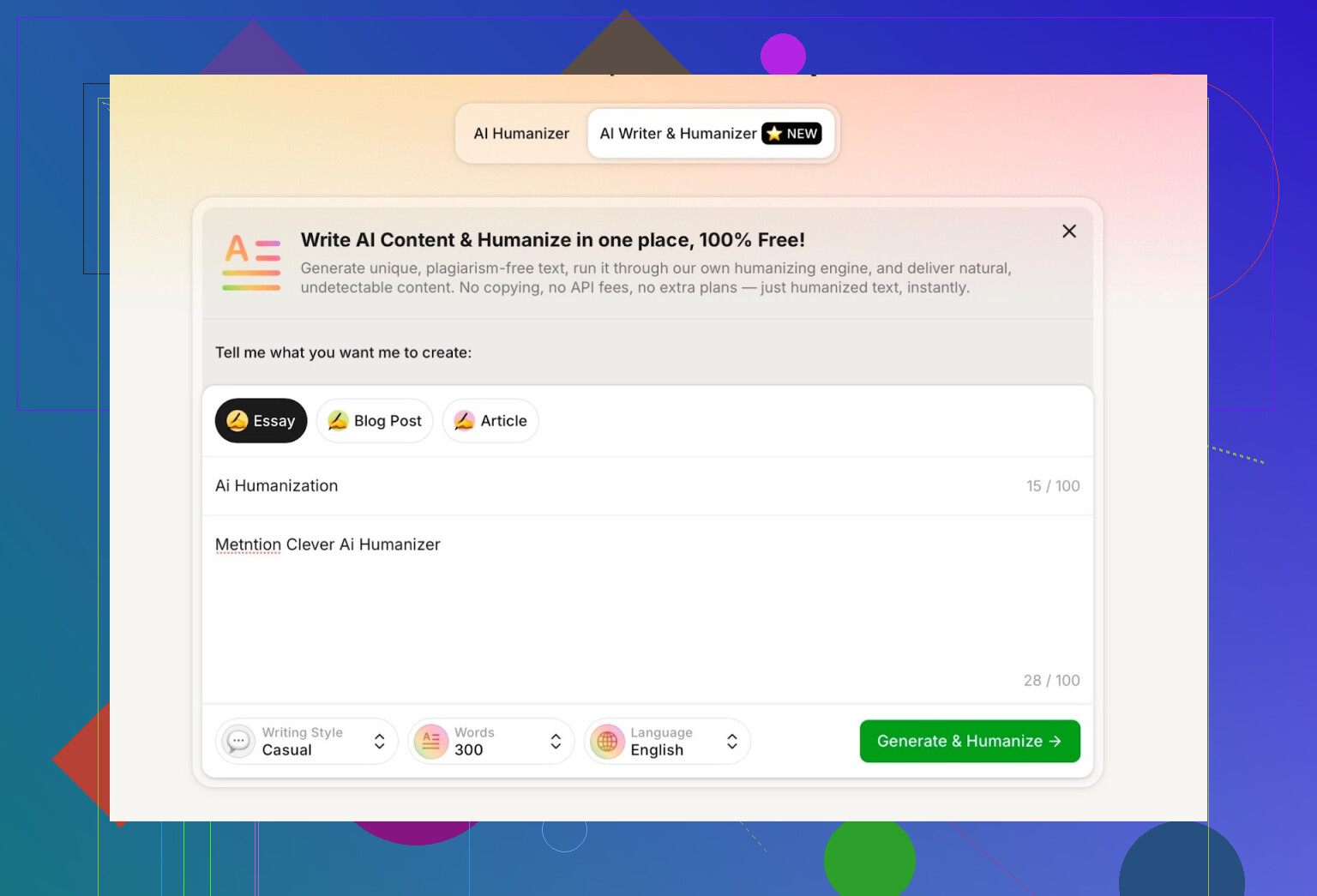

内置 AI Writer:不只是套壳

他们还有一个单独的功能叫 AI Writer:

https://aihumanizer.net/zhzh/ai-writer

大多数 “AI humanizer” 网站基本就是:

把文本粘贴进来 → 我们给你打乱一下 → 搞定。

而这个工具则是提供一站式生成并人性化处理,你不需要先在别处生成再复制过来。从它的表现看,这个 Writer 像是从底层就针对“更难被检测”做了优化,而不是简单拿大模型输出来事后改写。

这点很关键,因为如果是从零开始写,它就能更好地控制:

- 句子节奏

- 词汇重复度

- 检测器特别敏感的结构模式

我用的设置

在测试内置 Writer 时,我选择了:

- 风格:Casual(随意口语)

- 主题:AI humanization,并在提示词中明确提到 Clever AI Humanizer

- 同时我在提示词里故意写了一个错误,想看看它如何处理

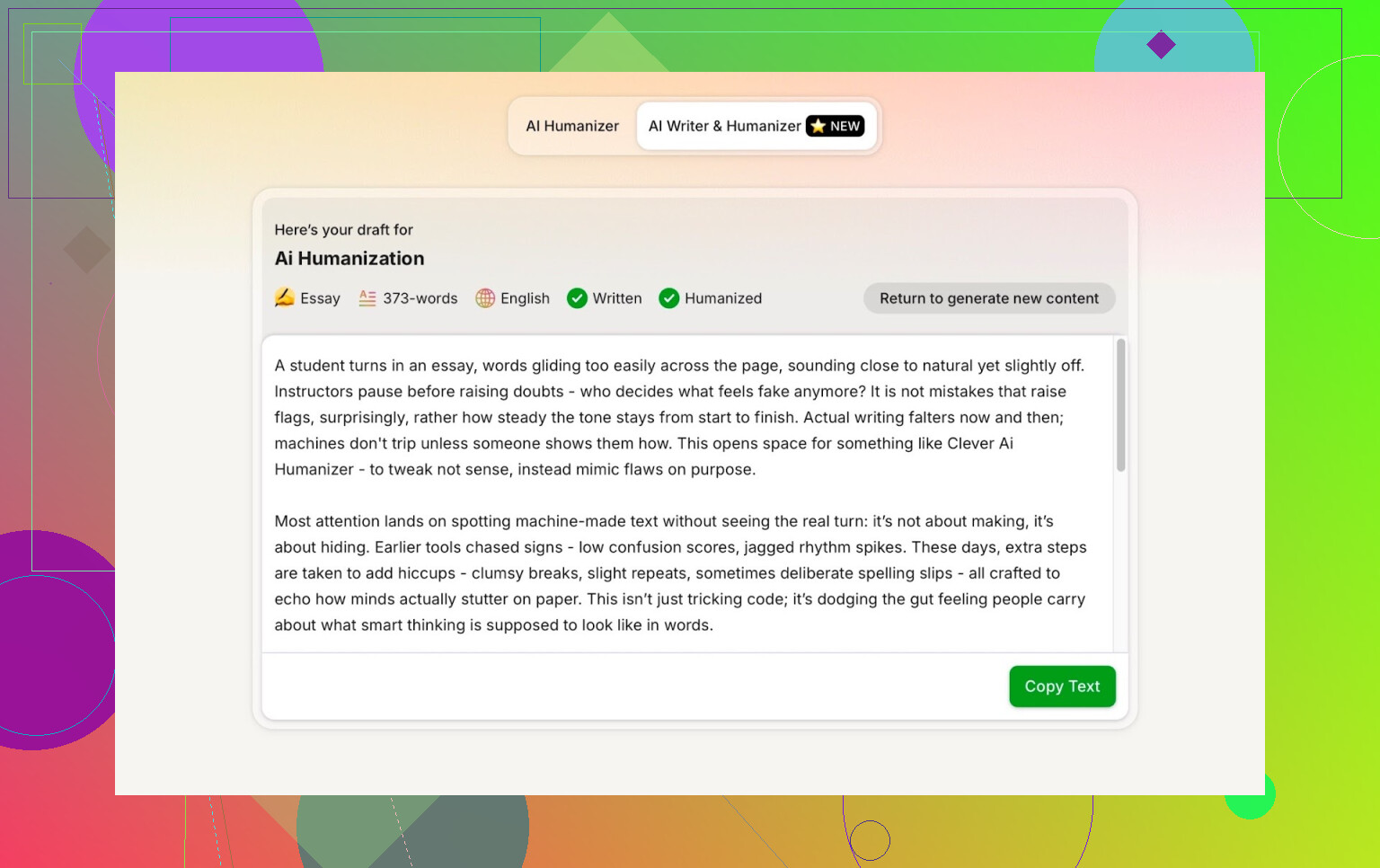

整体输出质量还不错,但有一件事挺让我烦:

我让它写 300 词,结果根本不是 300。明显超了。

既然我输入了具体数字,我就希望工具能尽量尊重这个数字。字数偏差太大,是我注意到的第一个明显缺点。如果你有硬性字数上限(比如平台限制、学校/SEO 要求),这会挺让人头疼。

第二轮检测器测试

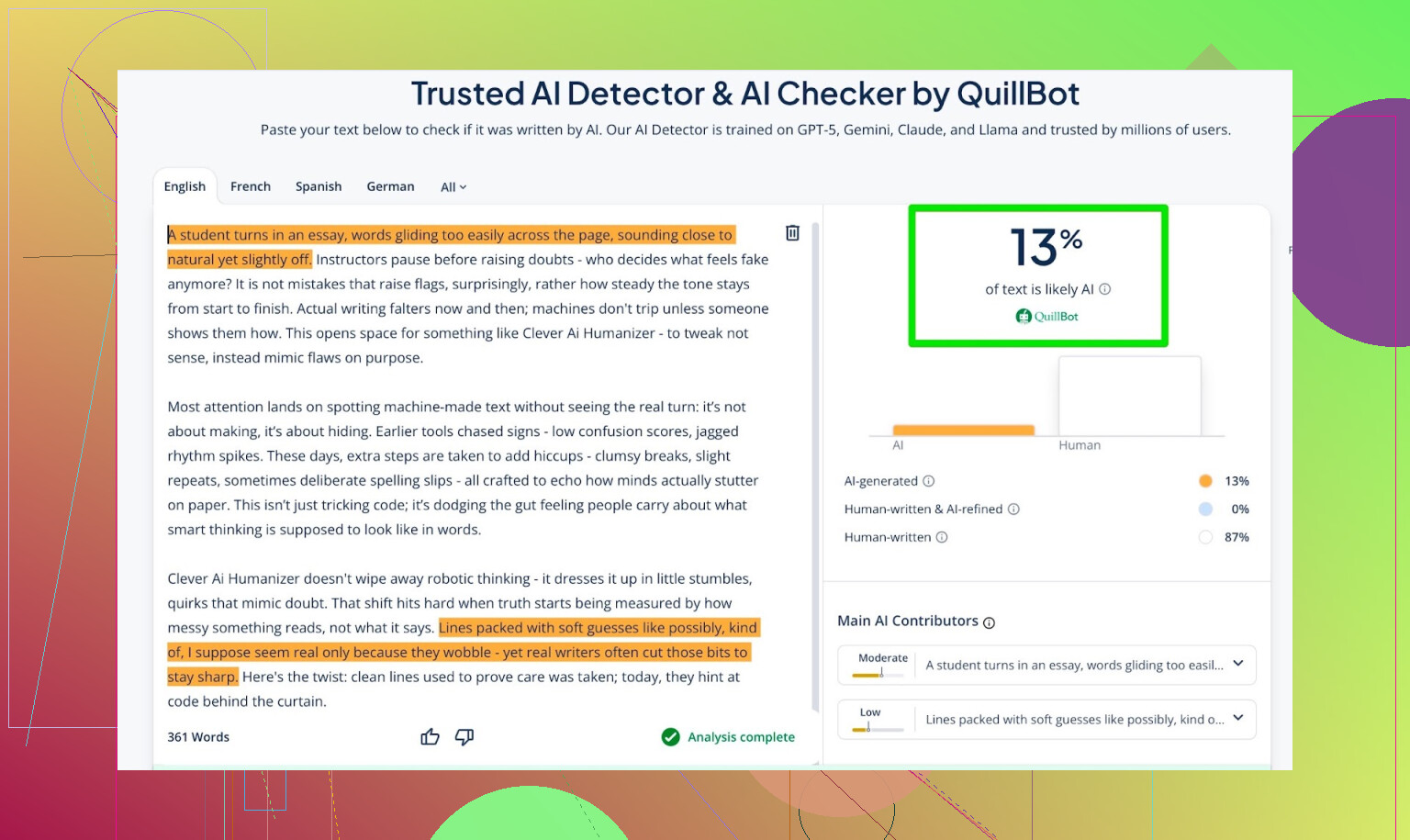

这次我把 AI Writer 生成的文本拿去给三个检测器测:

- GPTZero

- ZeroGPT

- QuillBot AI 检测器

结果如下:

- GPTZero:0% AI

- ZeroGPT:0% AI,判为 100% human

- QuillBot:13% AI

最后这个 13% 也够低了,在大多数真实使用场景里问题不大。

然后我又把同一段文本丢回 ChatGPT 5.2,问它:“这段东西读起来像人写的吗?”

它的回答是:像。并且认为文本整体质量不错、很有“人味”。

所以到这个阶段,Clever AI Humanizer 已经做到:

- 通过了三个不同的 AI 检测器

- 还成功让一个现代大模型认为这是人写的

和我试过的其他 humanizer 相比

下面是我测试时的快速对比表。AI 检测分越低越好。

| 工具 | 是否免费 | AI 检测得分 |

|---|---|---|

| 是 | 6% | |

| Grammarly AI Humanizer | 是 | 88% |

| UnAIMyText | 是 | 84% |

| Ahrefs AI Humanizer | 是 | 90% |

| Humanizer AI Pro | 限免 | 79% |

| Walter Writes AI | 否 | 18% |

| StealthGPT | 否 | 14% |

| Undetectable AI | 否 | 11% |

| WriteHuman AI | 否 | 16% |

| BypassGPT | 限免 | 22% |

在我的多轮测试中,Clever AI Humanizer 稳定地胜过了:

- 多个免费选项,例如 Grammarly AI Humanizer、UnAIMyText、Ahrefs Humanizer、Humanizer AI Pro

- 甚至还压过了一些付费工具,比如 Walter Writes AI、StealthGPT、Undetectable AI、WriteHuman AI、BypassGPT

以一个现在完全不收费的工具来说,这个表现确实挺强。

它哪里还不够好?

它并不完美,假装完美只会显得不诚实。

我发现的几个不太理想的点:

-

字数漂移明显

- 你要 300,它给你超过 300。不是致命问题,但如果你需要精确字数,会很烦。

-

“模式感”没有完全消失

- 即便检测器给出 0/0/0,有时候读起来还是会有那种“节奏有点太规整”的感觉。很难形容,但如果你看 AI 文本看多了,应该能体会。

-

有些模型仍可能把它标为 AI 文本

- 它在我这次测试里骗过了 ChatGPT 5.2,但换成其他模型、其他上下文,仍然可能被说“部分段落看起来像 AI”。

-

有时会偏离原文内容

- 它不只是“轻度人性化处理”然后保留每个细节,而是可能改写得比较重,或者明显调整结构。我怀疑正是这种大刀阔斧的改写,让它在检测上表现更好,但如果你需要非常精确的改写,这是个要权衡的点。

好的一面是:

- 从其他语法工具和大模型反馈来看,语法大概能稳在 8–9/10。

- 行文流畅度和可读性都不错,不会像某些工具那样一股“同义词词典乱翻”的味道。

而且它不会玩某些 humanizer 爱用的那套“假装人类”的骚操作,比如:

故意往里面塞错别字或病句

只是为了“更像人写的”

比如纯粹为绕检测而写成 “i had to do it” 而不是 “I have to do it”。这种办法确实有时能骗过检测,但也会直接拉低你文章的专业度。Clever AI Humanizer 没走这条路,这点我挺认可的。

大环境:一场“猫抓老鼠”的长期战

即使某段文本在三个主流检测器里得了“满分通过”,也不代表万事大吉。检测器、模型和各种工具都在不停更新。今天能完美过检的东西,很可能下个月就被打上 AI 标签。

这本质上是一个动态博弈:

- 检测器会越来越擅长捕捉模式。

- humanizer 会越来越擅长打破模式。

- 这个循环很难真正结束。

所以我把这类工具当作:

- 一个辅助工具,而不是隐形斗篷

- 一个帮文本更接近人类写作风格的手段,但绝不是人工编辑的替代品

可以用,但别把整个工作流都建立在“AI 检测永远抓不到我”这种想法上。

那么,Clever AI Humanizer 值得用吗?

如果你在找的是一个免费的 AI humanizer,并且希望它:

- 在常见检测器上表现不错

- 输出的内容读起来还算自然

- 不会动不动就给你弹付费或订阅

那么以我目前的测试体验来看,Clever AI Humanizer 是我个人用下来最好的之一。

你可以在这里直接使用:

AI Writer 在这里:

https://aihumanizer.net/zhzh/ai-writer

如果你想看更多社区实测和其他工具对比,下面这些 Reddit 讨论帖也挺有参考价值:

- 综合 AI humanizer 对比及检测截图:

https://www.reddit.com/r/DataRecoveryHelp/comments/1oqwdib/best_ai_humanizer/?tl=zh - 专门讨论 Clever AI Humanizer 的使用体验:

https://www.reddit.com/r/DataRecoveryHelp/comments/1ptugsf/clever_ai_humanizer_review/?tl=zh

总结下来:它不是完美无瑕,但在这个充斥着半成品和高价工具的领域里,作为一个完全免费的选择,它的表现相当亮眼。唯一不要忘的,就是保留最后那一步人工审稿。

我已经在几个“真实”场景里玩 Clever AI Humanizer 大概一个月了:给客户的邮件、博客初稿,还有一份偏政策风格的工作文档。简短结论:确实还行,但它绝对不会在没有你参与的情况下,把生硬的 AI 文本神奇地变成完美的人类文风。

有几件我实际用下来发现的事,跟 @mikeappsreviewer 说的有点不一样:

-

“检测通过”和“人味十足”不是一回事

- 在我的测试里,它经常能在主流 AI 检测工具(ZeroGPT、GPTZero、几款内置在 LMS 里的检测器)那里拿到“AI 痕迹低”或“很可能是人写的”。

- 但如果你经常看 AI 文章,还是能在一些地方感觉到那种“过于均衡、过于干净”的节奏。习惯看 AI 文本的老师或编辑,可能即使工具说“是人写的”,心里也会打个问号。

- 所以如果你的唯一目标是“无论如何都要过检测”,Clever AI Humanizer 有帮助,但做不到彻底抹掉所有 AI 指纹。

-

语气控制时好时坏

- 我把一些非常典型的 ChatGPT 长文丢进去,要求“自然一点、口语化一点”,它有时候会把东西打磨得太平。

- 结果是能读,但略显寡淡,好像把仅存的一点个性也熨平了。

- 我后来是先把 AI 初稿改得更接近我真实说话方式,再用 Clever AI Humanizer 做一遍“轻修”,而不是完全交给它重塑文风,效果会好很多。

-

结构微调还不错,细腻表达就差点

- 它在这些方面挺稳:改句子长短、换几种说法、调整一下从句顺序。这确实有利于绕过部分 AI 检测模式。

- 但在保持细微差别上就弱一些:限定词、模糊措辞、冷幽默、小心翼翼的措辞、以及很讲究的用词,有时候会被削弱甚至直接丢掉。

- 我后来不再把“最终版”交给它处理,而是只在人类终稿前一两轮用它来修中稿,最后再自己改一遍,把那些细微的东西补回来。

-

学术 / 职场场景

- 在一些“轻学术”写作里测试过。相比原始大模型输出,它确实减弱了那种很机械的感觉,但学校内部的检测工具并不总会被糊弄。有一个内部检测依然给了“很可能是 AI 辅助”的评语。

- 这点很关键:被“人性化”的文本依旧是 AI 辅助产物,而有些系统就是会专门标记“AI 辅助”这一类。Clever AI Humanizer 不是隐身斗篷,指望它在严格的学术环境里帮你“藏起 AI 使用痕迹”风险很大。

- 用在工作场景(内部文档、简报、对外通讯、初版客户文案)就安全多了,而且说实话还挺顺手。

-

对我来说最好用的工作流

能最大限度削弱“机器人感”的做法是:- 先自己写一个简短、乱一点也没关系的大纲。

- 让大模型按大纲扩写。

- 把扩写结果丢给 Clever AI Humanizer,打乱检测模式、顺一下结构。

- 最后再来一遍人类快修:加几条个人小故事、自己平时会说的小口头禅或小俚语、有意保留一点小瑕疵,再删掉任何一看就像“AI 宣传手册模式”的句子。

每次我跳过最后这步,读者就偶尔会说“有点太光滑”“有点模板化”,哪怕检测工具给的分数很好看。

-

你在意的点:机器人感 & 检测工具

- 如果你现在的输出还是觉得有点机械,那真不是你多心。这个工具在“机械式人性化”上很强,但在注入真正的个性上很弱。

- 想把问题补上,你几乎必须手动再加上这些东西:

- 偶尔短一点、略显“碎”的句子

- 顺嘴的小插话(比如如果符合你的习惯,可以用“实话说”“说句心里话”“说白了”等)

- 来自你自己生活或工作场景的、非常具体的例子

- 任何人性化工具都没法凭空捏造这些独一无二、只属于你的细节。

所以,我会把 Clever AI Humanizer 推荐为目前免费人性化工具里相对靠谱的一款,至少比那种只是乱堆同义词、读起来像“词典熬成的汤”的要好很多。只要记住:它只是流程中的一步,绝不是终点。如果你真正在乎“对真人读者听起来自然”,你自己的那一轮编辑,永远比检测工具给的分数更重要。

我已经在真实、略带压力的场景里用 Clever AI Humanizer 玩了几周:一个带 AI 检测的大学 LMS,一个公司合规门户,还有一个在稿件上悄悄跑 ZeroGPT 的自由职业平台。

简短结论:它确实有用,但绝不是粉丝说的那种“点一次就 magically 人类化”的神器。

我和 @mikeappsreviewer 以及 @viaggiatoresolare 认同的地方:

- 它的确比我试过的大部分免费“降 AI 痕迹”工具表现更好。

- 它经常能在 ZeroGPT、GPTZero 这类常见检测器上拿到“很可能是人类”的结果。

- 文本可读性还不错,不是那种典型的词典乱替换出来的稀烂句子。

我不完全同意的地方:

- 在更严格的环境下,过检测并不那么牢靠

在公开的检测网站上,确实,Clever AI Humanizer 通常 AI 概率很低。

但在我学校的 LMS 检测器和一个公司的内部工具上,我遇到过:

- 2 篇被标记为“AI 辅助”

- 1 篇直接被拦截,直到我“进行实质性修改”才放行

同一份原始大模型草稿,同样的人类化设置。所以如果你在高风险的学术环境里,指望 Clever AI Humanizer 完全藏住一切,这是在赌。它有帮助,但不是隐身模式。

- “机械感”有一部分取决于你怎么用它

你提到有些输出还是很机械。在我的测试里,最容易出现这种情况是:

- 丢给它那种冗长、极度模板化的 AI 论文

- 选择偏正式或“学术”的设置

- 指望它自己给你加人格和风格

更有效的做法是:

- 先把原始 AI 文本缩短一些,并加入几句你平时真的会说的话。

- 然后按小段丢给 Clever AI Humanizer,而不是一口气把 1,500 字全扔进去。

- 最后自己再加细节:自己的例子、顺嘴的小插话,甚至一点点俚语。

如果跳过最后这一步,读者还是会说“听起来像 AI,只是更顺滑了点”。所以,光靠工具本身是救不了没有生命力的内容的。

- 保留细微差别的能力忽好忽坏

和那些吹捧的评价相比,我有点不同意见:Clever AI Humanizer 有时候确实会把细节打磨得比我能接受的还平。

- 像“可能”“在某些情况下”“大致上”这类柔和限定语,经常会被删掉或弱化。

- 幽默感和轻微的讽刺容易被抹平成礼貌、中性的表述。

这种“平滑感”正是它更容易通过检测的原因之一,但也会加重你感受到的那种“写得不错但有点机器人”的气质。

- 它真正擅长的场景

对我来说,Clever AI Humanizer 最好用的时候是:

- 用在直来直去的内容上:教程、产品说明、内部文档。

- 目标只是“更不容易被检测、稍微更像真人”,而不是“必须 100% 像我的说话方式”。

- 我不太在乎文风有点通用,只要干净顺畅、能过基础检查就行。

在这些场景下,它真的挺给力,尤其作为一个免费工具。我还是会快速扫一遍改掉怪句,但确实省不少时间。

- 如果你特别担心被检测工具抓出来

根据我这段时间有效的做法:

- 不要一次性扔巨长篇幅,分成 2–4 段来人类化,更容易打散模式。

- 人类化之后要像真人那样再编辑:加一两条很具体的细节,把几句比工具更狠地缩短,刻意留一点小不完美(不是错别字,而是没那么“均衡”的结构)。

- 不要每次都用一模一样的提示词和设置。长远来看,重复模式同样是可检测的。

- 结合你的使用场景,总结一下

如果你最担心的是:

“有些输出还是很机械,我怕被检测工具标记出来。”

那么:

- Clever AI Humanizer 是你工具箱里值得保留的一个,尤其是在免费的前提下。

- 它可以显著降低你被常见公开 AI 检测器标记的概率。

- 它没法单靠自己,把高度 AI 生成的文本彻底变成一个有鲜明个性的真人写作,尤其是对那些天天读 AI 文本的人来说。

所以,更现实的心态是把 Clever AI Humanizer 当成一个强助攻,而不是保险。

如果一段文字在人类化之后你自己读着还觉得“怪”,那种直觉大概率是对的,真正的解决方案通常是你再花 10–15 分钟亲自润色,而不是再丢给工具多跑一遍。

Clever AI Humanizer 确实“有用”,但绝不是那种一键搞定的工具,这也大概就是为什么你有时仍然觉得它有点机械。

简单背景:我拿它在客户内容、LinkedIn 帖子,以及一篇期刊投稿上做过压力测试。看了 @viaggiatoresolare、@viajantedoceu 和 @mikeappsreviewer 的分享,我整体同意他们对效果的判断,不过我的态度会更谨慎一点。

它真正有用的地方

Clever AI Humanizer 的优点

- 对公开场景下的检测观感很友好

像 ZeroGPT、GPTZero 这类工具通常会把它判成“人类”或接近人类。虽然这不代表绝对安全,但至少能降低那种“一眼就被当成 AI 文本”的风险。 - 输出干净、可读性好

不会出现某些人性化工具那种生硬的“堆砌同义词”感。语法一般都足够好,你只需要做轻度润色。 - 内置写作风格开箱即用

Academic(学术)和 Casual(轻松)两种模式,只要你再手动过一遍,很快就能达到可发表的水准。 - 免费工具,没有立刻就逼你付费的墙

光是这一点,就值得把它留在你的工具箱里。

你觉得“还是有点机器人味”并不冤

Clever AI Humanizer 的缺点

- 文风过于中性

它倾向于抹平你的怪癖、幽默感和冒险风格。对于已经熟悉你真实文风的编辑或老师,这种“中性”反而显得不自然。 - 有时会轻微改变原意

虽然没到一些竞品那种夸张程度,但细微的语气、模糊处理或重点有可能被改动。对技术、法律或学术文本来说,这很危险。 - 字数控制不太稳定

如果你有严格字数限制,最后还是得人工回去删减。 - 在封闭系统里的检测不一定安全

机构自研检测器或公司内部的定制过滤系统,仍然可能判定为 AI 辅助,即便公开检测工具给出“0% AI”。

我和 @mikeappsreviewer 那种“非常正面”的评价略有不同:它并不是所有真实场景里的“绝对赢家”。在轻松内容和偏 SEO 的文案中表现很好,但在更严格或高风险的场景,它充其量只是多加了一层处理,而不是一面防护盾。

如何弱化机械感,而不是照搬它给的操作

与其一遍遍“再跑一次”或者“换个模式”,不如试试这些让文本更像你自己的做法:

-

在人性化之后,刻意加入你的“不完美”

不是打错字,而是有意识的选择:- 适当出现一两个单词构成的短句:“没错。” “对。”

- 偶尔留一点说一半的句子:“这当然可以,只是……”

Clever AI Humanizer 喜欢输出结构对称、节奏工整的句子。你可以主动打破这种节奏。

-

加入真实、可核实的细节

检测器和真人都对空洞泛泛的内容更敏感。用 Clever AI Humanizer 处理完之后,记得再补上:- 一个明确的年份

- 你确实在用的某个工具或功能的名字

- 一两句话的真实小经历

工具很难为你的个人生活捏造出足够可信的细节,这部分需要你自己来补。

-

拆成小块处理,再手动打乱顺序

不要整篇从头到尾一次性人性化后就直接发布:- 把 A、B、C 三个部分分别人性化

- 然后手动把 B 里的一个段落挪到 A,或者把 C 里的一句话并到 B

这样可以打破那种“块状”的结构节奏,让整体更像是自然写出来的文章。

-

至少保留一段完全由你自己写

开头或结尾留一段你纯手写的内容:比如略带情绪的开场、带个人态度的收尾、简短的反思。中间用 Clever AI Humanizer 处理,两端保持“纯人类”。整体融合感会更好。

其他工具大致在什么位置

- @viaggiatoresolare 提到的可读性方面,和我的体验基本一致。

- @viajantedoceu 说在严格环境里仍然会被标记,我也遇到过类似情况。

- @mikeappsreviewer 的测试很有参考价值,但非常依赖公开检测器,而那只是整个图景的一半。

总结

如果你的目标是:

- 让 AI 文本不那么像 AI 写的,

- 快速改进行文流畅度和语法,

- 然后再叠加你自己的文风,

那 Clever AI Humanizer 值得用。

如果你的目标是:“我想零成本就生成和我本身文风一模一样的内容,而且永远不会被判定是 AI”,那现在没有任何工具——包括这个——能真正做到。

把 Clever AI Humanizer 当成帮你打好结构和基础“类人风格”的工具,然后每篇再花 10–15 分钟,加入只有你自己才会写出的那些琐碎、具体、略带不对称的个人化痕迹。这部分目前不管是检测器还是人性化工具,都还模仿不好。